反向传播、前向传播都不要,这种无梯度学习方法是Hinton想要的吗?

文章摘要

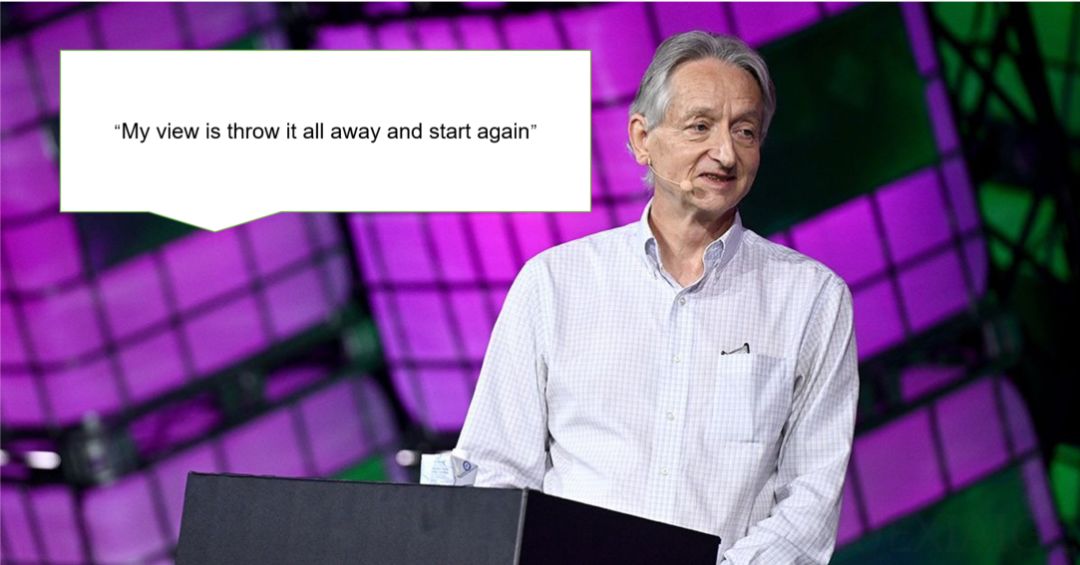

反向传播作为深度学习的主流方法,近年来因其生物学不合理性、内存消耗大以及并行计算受限等问题,逐渐受到质疑。Geoffrey Hinton等人一直致力于寻找替代方案,但此前的研究如前向-前向算法在性能和可泛化性方面仍存在不足。最近,牛津大学和Mila实验室的研究者提出了一种名为NoProp的新型学习方法,该方法不依赖前向传播或反向传播,而是从扩散和流匹配方法中汲取灵感,通过每一层独立地学习对噪声目标进行去噪,实现了无梯度的学习过程。

NoProp的核心思想是预先将每一层的表示固定为目标的带噪声版本,学习一个局部去噪过程,并在推理时利用这一过程。这种方法不学习传统的分层表示,而是通过独立的、无梯度的层训练,绕过了反向传播中基于顺序梯度的贡献分配方式,实现了更高效、可并行化的更新。研究者在MNIST、CIFAR-10和CIFAR-100图像分类基准测试中验证了NoProp的有效性,结果表明其准确率优于现有的无反向传播方法,且计算效率更高。

NoProp的数学公式涉及每层特定的噪声模型和优化目标,使得无需梯度链即可进行独立学习。通过让每一层独立地对一个固定的噪声目标进行去噪,NoProp避免了梯度消失等问题,尽管它并未构建传统的层次化表示。这种方法在分布式学习系统中具有潜在的重大影响,因为它从根本上改变了贡献分配机制。

反向传播的替代方案探索主要基于三个原因:生物学合理性不足、内存消耗大以及并行计算受限。尽管无梯度方法、零阶梯度方法、进化策略和基于局部损失的方法等替代方案已被提出,但由于在准确性、计算效率、可靠性和可扩展性方面的限制,尚未在神经网络学习中广泛应用。NoProp的出现为这一领域提供了新的可能性。

在实验部分,研究者在离散时间和连续时间设置下对NoProp进行了评估。结果显示,NoProp在离散时间设置下的性能与反向传播方法相当,甚至更好,且在训练过程中减少了GPU内存消耗。在连续时间设置下,NoProp的准确率虽略低于离散时间设置,但仍优于伴随敏感性方法,尤其是在计算效率方面。此外,研究者还通过消融研究探讨了类别概率的参数化和类别嵌入矩阵的初始化对性能的影响,结果表明正交初始化和原型初始化通常优于随机初始化。

NoProp的成功表明,通过摆脱传统的基于梯度的学习范式,可以实现更高效的分布式学习,并可能影响学习过程的其他特性。这一开创性工作为未来的神经网络训练方法提供了新的思路,尤其是在大规模分布式学习系统中具有广泛的应用前景。

原文和模型

【原文链接】 阅读原文 [ 2931字 | 12分钟 ]

【原文作者】 机器之心

【摘要模型】 deepseek-v3

【摘要评分】 ★★★★★