开源赛道太挤了!月之暗面开源新版Muon优化器

文章摘要

【关 键 词】 优化器、计算效率、模型性能、开源代码、技术改进

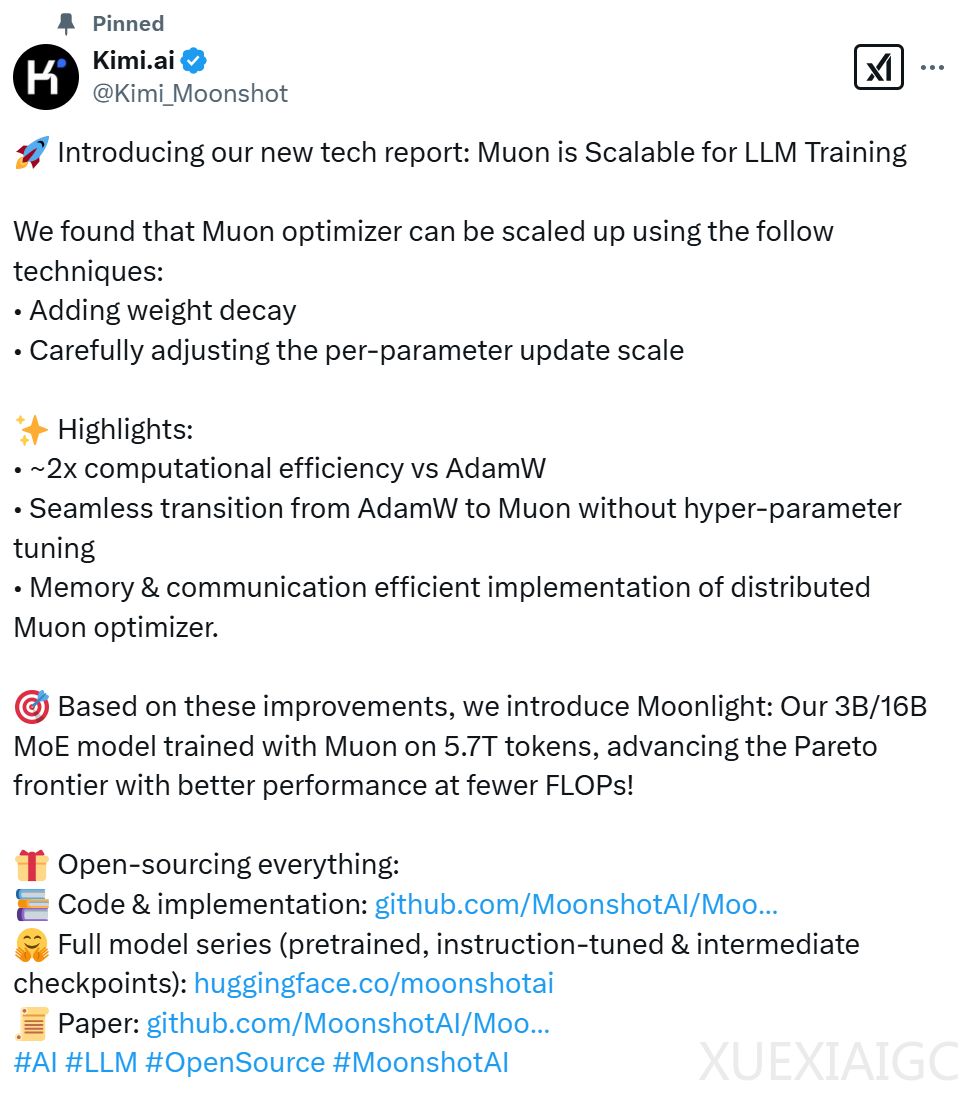

月之暗面近期开源了改进版优化器Muon,其计算效率较AdamW提升2倍,并在相同训练预算下显著提升模型性能。通过引入权重衰减和一致的RMS更新技术,Muon成功解决了原始版本在扩展至大模型时权重增长超限的问题。实验数据显示,改进后的Muon仅需52%的训练FLOPs即可达到与AdamW相当的效果,验证损失更低,收敛稳定性更强。

在技术实现层面,研究团队针对矩阵参数更新过程中的RMS不一致性进行了优化调整,通过数学推导和实验验证,提出缩放因子修正方法,使不同形状参数的更新幅度保持均衡。分布式Muon方案结合ZeRO-1数据并行策略,在保持通信效率的同时实现了优化器状态划分,算法设计包含梯度预处理和参数更新同步等关键步骤,确保大规模训练可行性。

基于Muon优化的Moonlight模型展现了显著优势。该3B/16B参数的MoE模型经过5.7万亿token训练,在语言理解、数学推理和代码生成等任务中全面超越同类模型。与DeepSeek-V3-Small等基线模型相比,Moonlight在相同计算资源下实现了更优的帕累托前沿表现,验证了优化器改进对模型性能的直接影响。特别在MoE架构中,Muon促使专家权重呈现更高多样性,提升了模型表达能力。

研究团队公开了完整的技术实现细节,包括内存优化代码、预训练模型及中间检查点。Scaling Law分析表明,Muon在计算最优训练场景下可将效率提升近一倍,这一突破为降低大模型训练成本提供了新路径。值得注意的是,当预训练与微调阶段均采用Muon时,模型性能增益最为显著,这提示优化器一致性对迁移学习效果具有重要影响。

实验数据进一步揭示了技术改进的深层价值:权重衰减机制有效抑制了参数膨胀,使模型在长周期训练中保持稳定;RMS一致性调整则解决了不同维度矩阵更新的尺度偏差问题。在修改MLP层结构的对比实验中,调整学习率的方法以更低计算成本实现了优于基线模型的效果,验证了技术方案的有效性。这些发现为优化器设计提供了新的理论依据和实践参考。

原文和模型

【原文链接】 阅读原文 [ 2274字 | 10分钟 ]

【原文作者】 机器之心

【摘要模型】 deepseek-r1

【摘要评分】 ★★★★★