开源22万条DeepSeek R1的高质量数据!你也能复现DeepSeek了

文章摘要

【关 键 词】 开源模型、数据生成、数学推理、社区协作、模型复现

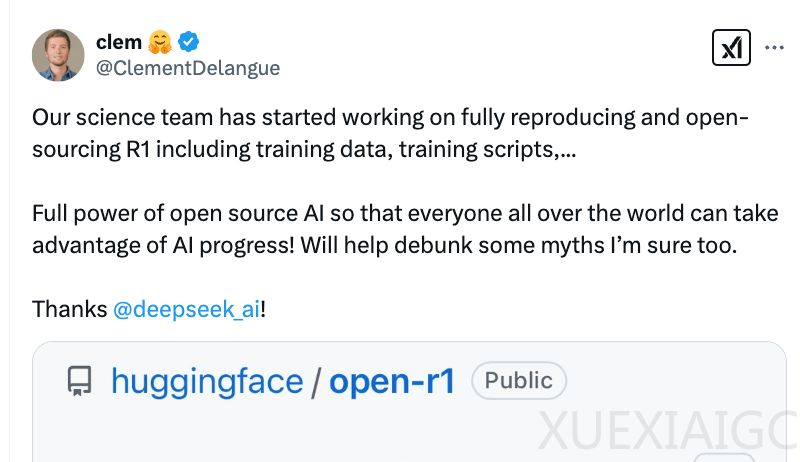

DeepSeek-R1模型的开源引发了全球技术社区对模型复现的热潮,其中Hugging Face主导的Open R1项目成为焦点。该项目通过公开训练代码、评估工具和合成数据集,致力于完整复现DeepSeek-R1的技术细节。最新发布的OpenR1-Math-220k数据集填补了原模型未公开的数学推理数据空白,包含22万条经过严格筛选的高质量数学问题解答轨迹。该数据集基于NuminaMath 1.5框架构建,通过本地集群使用512个H100 GPU实现高效生成,日均产出18万条数据,并采用SGLang技术将生成速度提升近两倍。

数据质量控制体系包含双重验证机制:首先通过改进的Math-Verify工具进行数学表达式比对,再利用Llama-3.3-70B-Instruct模型对格式异常的答案进行语义复核,成功挽回2.5万条有效数据。实验显示,基于该数据集训练的Qwen-7B-Math-Instruct模型性能已接近DeepSeek官方蒸馏版本,在数学基准测试中展现出可比拟的推理能力。值得注意的是,研究团队尝试用奖励模型筛选最优答案的方案并未显著提升效果,暗示推理过程质量可能比最终答案选择更具影响力。

开源社区的探索揭示了模型能力提升的新路径。研究表明,仅需1000个高质量训练样本即可有效激发现有模型的推理潜力,如s1K数据集通过精选数学问题使Qwen2.5-32B-Instruct在竞赛数学测试中超越OpenAI o1-preview模型。同时,马里兰大学的研究提出隐式推理方法,通过潜在空间探索实现高效计算,为优化推理效率提供新思路。

在技术方法层面,思维链(CoT)长度的控制策略引发关注。预算强制技术通过动态调整推理token数量,证实了延长思考时间与模型准确率的正相关性。而余弦奖励函数的引入,则有效平衡了CoT长度与训练稳定性,配合重复惩罚机制防止无效推理循环。这些发现为优化模型推理过程提供了可操作框架。

Open R1项目持续推进技术突破,其GRPO实现已整合至TRL框架,团队正系统探索超参数与奖励函数的影响边界。随着计算集群规模扩大和生成技术优化,开源社区正加速逼近商业模型的性能边界,而测试数据过拟合等挑战也促使研究者寻求更可靠的新型评估体系。

原文和模型

【原文链接】 阅读原文 [ 3122字 | 13分钟 ]

【原文作者】 机器之心

【摘要模型】 deepseek-r1

【摘要评分】 ★★★★★