文章摘要

微软近期在官网开源了三个新版Phi-4小参数模型,分别是Reasoning、Min-Reasoning和Reasoning-plus。这些模型的最大亮点之一是算力消耗极低,能够在消费级硬件环境上运行,甚至在普通的Windows 11设备上也能轻松实现本地部署。微软已将Phi-4系列模型深度融入Windows系统生态,使其成为Copilot+PC的重要组成部分。

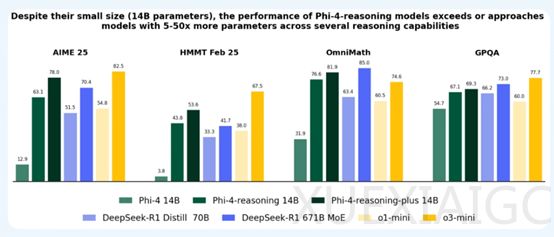

Phi-4-Reasoning-plus版本仅有140亿参数,但在多项测试中表现优异,与美国数学奥林匹克竞赛资格赛2025、哈佛-麻省理工数学竞赛、Ominimath和GPQA等测试中,其性能与DeepSeek开源的R1 6710亿参数模型相当,甚至在某些领域表现更优。例如,在美国数学奥林匹克竞赛资格赛2025中,Reasoning-plus得分为78,R1为70.4;在哈佛-麻省理工数学竞赛中,Reasoning-plus为53.6,R1为41.7;在Ominimath的测试中,Reasoning-plus为81.9,R1为85;在GPQA中,Reasoning-plus为69.3,R1为73。这些结果表明,Phi-4-Reasoning-plus是目前最强的开源小参数模型之一。

Phi-4-Reasoning的基础架构源自微软开源的Phi-4模型,为了提升其推理能力,微软采用了监督微调和强化学习相结合的训练方法。首先,通过监督微调让大模型学习高质量的推理演示数据,生成详细的推理链,并有效利用推理时的计算资源。这种方法类似于给模型提供了一个“标准答案”,使其知道如何正确地进行推理。然而,仅依靠监督微调是不够的,因为模型在某些领域可能仍然存在不足。因此,微软引入了强化学习阶段,尤其是对数学推理等特定领域帮助非常大。强化学习阶段通过奖励函数引导模型生成更准确、更深入的推理链,相当于为模型提供了一个“奖励机制”,鼓励模型在推理过程中更加努力地思考,从而提高推理的准确性和深度。

Phi-4-Reasoning模型在推理标记与长推理链支持方面也进行了创新。为了更好地支持推理过程,模型引入了特定的推理标记

此外,微软发现使用高质量和合成数据对于训练模型非常重要,于是从多个渠道收集了大量问题,包括公开网站、现有数据集。这些数据涵盖了数学、科学、编程以及与安全相关的任务等多个领域。还通过合成数据生成技术,将部分问题转换为新的形式。例如,将编程问题转换为文字问题,或者对数学问题进行改编,以更好地适应推理训练的需求。这种数据策划和合成策略不仅丰富了训练数据的内容,还为模型提供了更多样化的学习场景,从而提升了模型的泛化能力。

总体而言,Phi-4系列模型通过低算力消耗、深度融入Windows生态、强化学习训练方法、推理标记创新以及高质量数据的使用,展现了其在推理任务中的强大能力。这些模型的推出不仅为开发者和研究人员提供了强大的工具,也为未来人工智能的发展提供了新的方向。

原文和模型

【原文链接】 阅读原文 [ 925字 | 4分钟 ]

【原文作者】 AIGC开放社区

【摘要模型】 deepseek-v3

【摘要评分】 ★★☆☆☆