文章摘要

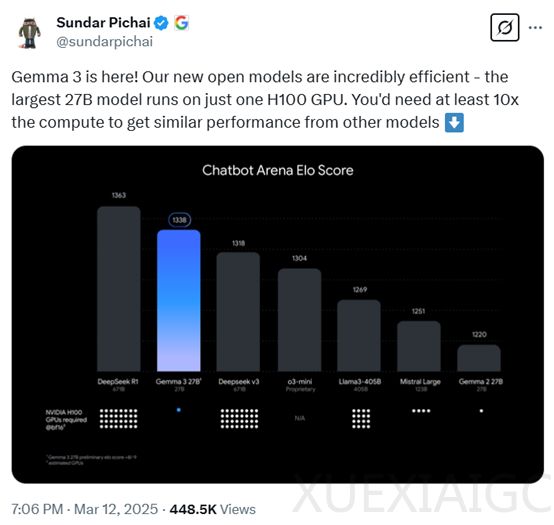

谷歌CEO Sundar Pichai宣布开源最新多模态大模型Gemma-3,该模型主打低成本高性能,共有10亿、40亿、120亿和270亿四种参数版本。即便最大的270亿参数版本,仅需一张H100显卡即可高效推理,相比同类模型,算力需求降低了10倍,成为目前最强的小参数模型。根据盲测LMSYS ChatbotArena数据显示,Gemma-3的性能仅次于DeepSeek的R1-671B,高于OpenAI的o3-mini和Llama3-405B等知名模型。Gemma-3的发布标志着谷歌正式加入低成本大模型的竞争行列。

在架构设计上,Gemma-3延续了前两代的通用解码器Transformer架构,但进行了多项创新和优化。为应对长上下文带来的内存爆炸问题,模型采用了局部和全局自注意力层交错的架构,每5个局部层之间插入1个全局层,局部层的跨度仅为1024个token。这种设计显著降低了内存占用,同时将上下文长度扩展到了128K token(10亿参数模型为32K)。Gemma-3还通过提高全局自注意力层的RoPE基础频率和采用位置插值方法,进一步提升了长上下文场景下的性能。

多模态能力是Gemma-3的一大技术亮点,模型能够同时处理文本和图像。它集成了定制版的SigLIP视觉编码器,并通过创新的图像嵌入压缩技术,将视觉嵌入压缩为固定大小的256个向量,显著减少了计算资源的消耗。此外,Gemma-3引入了Pan&Scan方法,灵活处理不同分辨率和宽高比的图像,提升了模型对复杂图像场景的理解能力。

在训练过程中,Gemma-3采用了与Gemma 2相似的方法,并融入了新的改进。模型使用了更大的token预算,以适应图像和文本混合数据的训练需求。270亿参数的模型训练使用了14T token,120亿参数模型使用12T,40亿参数模型使用4T,10亿参数模型使用2T。Gemma-3还增加了多语言数据,支持140种语言,其中35种语言开箱即用。模型使用与Gemini 2.0相同的SentencePiece分词器,具备分割数字、保留空格和字节级编码的特性,生成的词汇表包含262k个条目,使得模型在处理非英语语言时更加平衡。

在训练优化上,Gemma-3运用了知识蒸馏技术,每个token采样256个logits,按照教师概率进行加权,学生模型通过交叉熵损失来学习教师模型在这些样本中的分布。后训练阶段,模型采用了改进版的知识蒸馏技术,结合基于改进版BOND、WARM和WARP的强化学习微调阶段,进一步提升了模型的特定能力。通过多种奖励函数优化模型,提升了模型的帮助性、数学能力、编码能力、推理能力、指令遵循能力和多语言能力,同时最小化模型产生有害输出的可能性。

在性能测试中,Gemma-3在MGSM、Global-MMLU-Lite、WMT24++、RULER、MRCR等主流平台上进行了评估。结果显示,Gemma-3在多模态任务中表现出色,尤其在DocVQA、InfoVQA和TextVQA等任务中,性能显著优于前代模型。在长文本处理方面,Gemma-3的27B模型在RULER128K上达到了66.0%的准确率,展现了强大的长文本处理能力。在多语言支持上,Gemma-3在MGSM和Global-MMLU-Lite等任务中也取得了优异成绩。在对话能力评估中,Gemma-3的27B指令调优版本在ChatbotArena中的Elo分数为1338,排名进入前10,接近DeepSeek-R1等大型模型。

原文和模型

【原文链接】 阅读原文 [ 1451字 | 6分钟 ]

【原文作者】 AIGC开放社区

【摘要模型】 deepseek-v3

【摘要评分】 ★★★☆☆