文章摘要

【关 键 词】 长上下文、神经记忆、协同架构、算力优化、模型性能

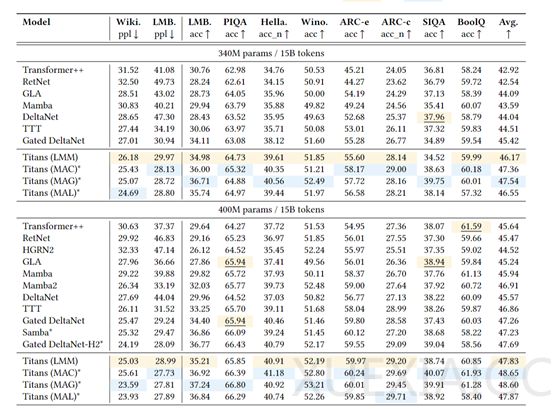

谷歌研究院推出的Titans框架通过创新架构设计突破了大语言模型的长上下文处理瓶颈,将模型上下文窗口扩展至200万token,同时仅增加1.8倍算力消耗。该框架在语言建模、基因组分析和时序预测等任务中全面超越传统Transformer及线性循环模型,为解决AI系统长期存在的记忆容量与计算效率矛盾提供了新范式。

传统Transformer模型因二次方计算复杂度限制,难以突破数万token的上下文窗口。现有改进方案通过压缩历史信息导致长程记忆能力受限,在长文档理解、DNA序列建模等场景表现欠佳。Titans通过模拟人类分层记忆机制,构建了包含神经长期记忆模块和三脑协同架构的系统。神经长期记忆模块采用双阶段梯度驱动机制,通过二阶导数量化”认知惊喜值”,动态触发记忆强化,实现了类似海马体的自主进化能力。

三脑协同架构将人脑认知系统映射为计算模型,包含三大核心组件:工作记忆通路采用改进型稀疏注意力机制,在128k token窗口内实现局部依赖建模,通过熵值分析动态调整注意力范围;长期记忆分支通过双向读写协议整合跨时空信息,其可微分最近邻搜索算法在蛋白质序列分析中达到92.7%的检索精度;持久知识库存储结构化跨领域知识,采用两阶段训练策略使医疗诊断任务中的罕见病识别准确率提升41%。三模块通过反馈环路实现局部与全局认知的统一,解决了传统架构的容量-效率悖论。

硬件层面通过卷积增强编码器和前瞻性内存优化技术,显著提升计算效率。在生物医学领域,该框架展现出独特优势:基因组分析中功能域检索精度较传统方法提升23%,医疗诊断误报率降低67%。记忆重要性衰减曲线预测模型可提前128个时间步预判信息生命周期,为超长上下文处理提供动态内存管理方案。这些技术创新为AIGC在科研、医疗等数据密集型领域的深度应用开辟了新路径。

原文和模型

【原文链接】 阅读原文 [ 1500字 | 6分钟 ]

【原文作者】 AIGC开放社区

【摘要模型】 deepseek-r1

【摘要评分】 ★★☆☆☆