TTS和TTT已过时?TTRL横空出世,推理模型摆脱「标注数据」依赖,性能暴涨

文章摘要

【关 键 词】 大语言模型、推理能力、测试时缩放、强化学习、无标注数据

在大语言模型(LLMs)竞争日益激烈的背景下,推理能力成为评估模型性能的关键指标。测试时缩放(TTS)作为一种新兴策略,通过优化推理过程(如多数投票、蒙特卡洛树搜索等)提升模型性能,而无需修改模型参数。研究表明,TTS在计算效率上优于预训练阶段扩大模型规模,能以更低资源成本实现更好表现。然而,TTS依赖预训练知识,在面对未标注新数据或输入分布变化时,泛化能力受限。例如,OpenAI的o3模型在基准任务上达到75.7%的成功率,但对更复杂的新任务仅能解决4%的问题。

为克服TTS的局限,测试时训练(TTT)一度受到广泛关注。TTT通过在测试阶段利用强化学习(RL)等技术动态更新模型参数,使模型适应新数据或任务,弥补了TTS在泛化能力上的不足。但TTT同样面临挑战:测试阶段缺乏奖励函数或验证信号,而人工标注数据的高成本使得无监督环境下的RL应用受限。

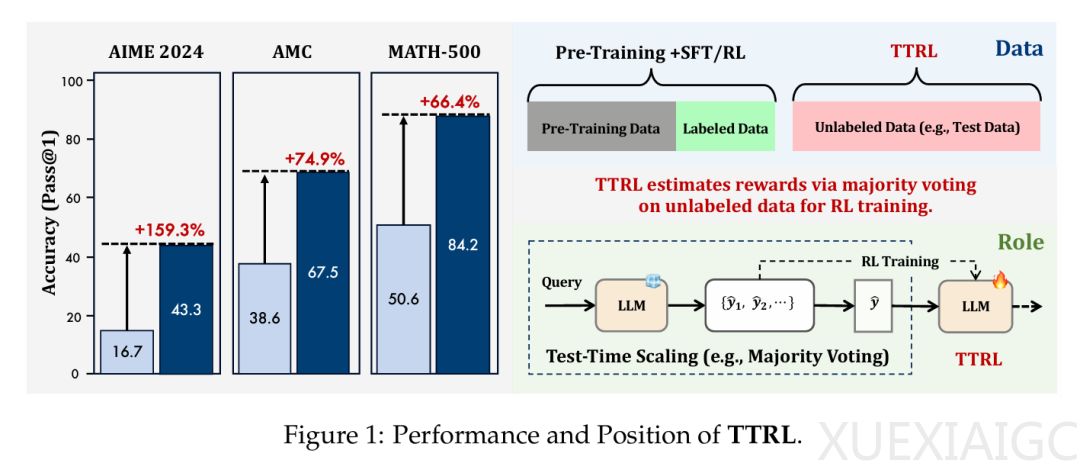

清华大学和上海人工智能实验室提出了一种新方法——测试时强化学习(Test-Time Reinforcement Learning,TTRL),该方法能够在无标注数据上对LLM进行强化学习训练。TTRL通过利用预训练模型中的先验知识,使LLM具备自我演化的能力。实验证明,TTRL在多种任务和模型上都能持续提升性能:在仅使用未标注测试数据的情况下,TTRL将Qwen-2.5-Math-7B在AIME 2024任务中的pass@1指标提升了约159%。

TTRL通过重复采样的方法生成多个候选输出,并使用多数投票或其他聚合方法推导出共识输出,作为近似的最优动作的替代。环境反馈的奖励根据当前动作与共识输出之间的一致性进行设定,模型的RL目标是最大化期望奖励。该方法能够在推理阶段实现模型的动态适应,无需标注数据即可提升模型应对分布变化输入时的性能。

在实验中,TTRL在大多数任务和模型上都表现出色。尽管TTRL完全依赖于使用无标注测试数据的自我进化,但其性能却可媲美基于大规模标注数据集训练的现有RL模型。例如,在AIME 2024上,TTRL实现了159.3%的大幅提升,超过了所有在大规模数据集上训练的模型。此外,当应用于Qwen2.5-Math-7B时,TTRL在三个基准测试中平均提高了84.1%。

TTRL的自然扩展行为表明,更大的模型可以在自我改进过程中产生更准确的多数投票奖励,从而更有效地学习新数据。例如,随着模型大小的增加(从1.5B到7B),其在AIME 2024和AMC上的性能提升也在增加。然而,LLaMA-3.1-8B-Instruct和Qwen2.5-Math-1.5B由于容量有限,未能通过TTRL在AIME 2024上取得有意义的进展。

TTRL在目标任务之外也有很好的通用性。研究者以Qwen2.5-Math-7B为骨干,在每个基准上执行了TTRL,并在其他基准上进行了进一步评估。结果表明,TTRL在所有基准上都取得了实质性的改进,表明其并没有依赖过拟合,而是在自我改进过程中获得了可推广的收益。

TTRL与不同的RL算法兼容,例如PPO和GRPO,其性能轨迹非常接近,PPO能产生更稳定的结果,同时实现相似的整体性能。研究者还分析了TTRL在无监督条件下实现稳定有效的RL的因素,包括标签估计和奖励计算。尽管存在奖励误差,TTRL仍能正常工作,原因在于RL可以容忍一定程度的奖励不准确性,且由政策模型本身估计的奖励信号可能会为学习提供更合适的指导。

然而,TTRL在某些情况下可能会失效,例如缺乏对目标任务的先验知识或不恰当的RL超参数。研究者发现,随着问题难度的增加,性能提高率和长度缩减率都呈下降趋势,表明主干系统的可用先验知识不足以支持对更具挑战性问题的学习。

总的来说,TTRL通过在测试阶段利用无标注数据进行强化学习训练,显著提升了LLM的推理能力和泛化性能,展示了其在更广阔领域中的应用潜力。

原文和模型

【原文链接】 阅读原文 [ 2898字 | 12分钟 ]

【原文作者】 机器之心

【摘要模型】 deepseek-v3

【摘要评分】 ★★★★★