文章摘要

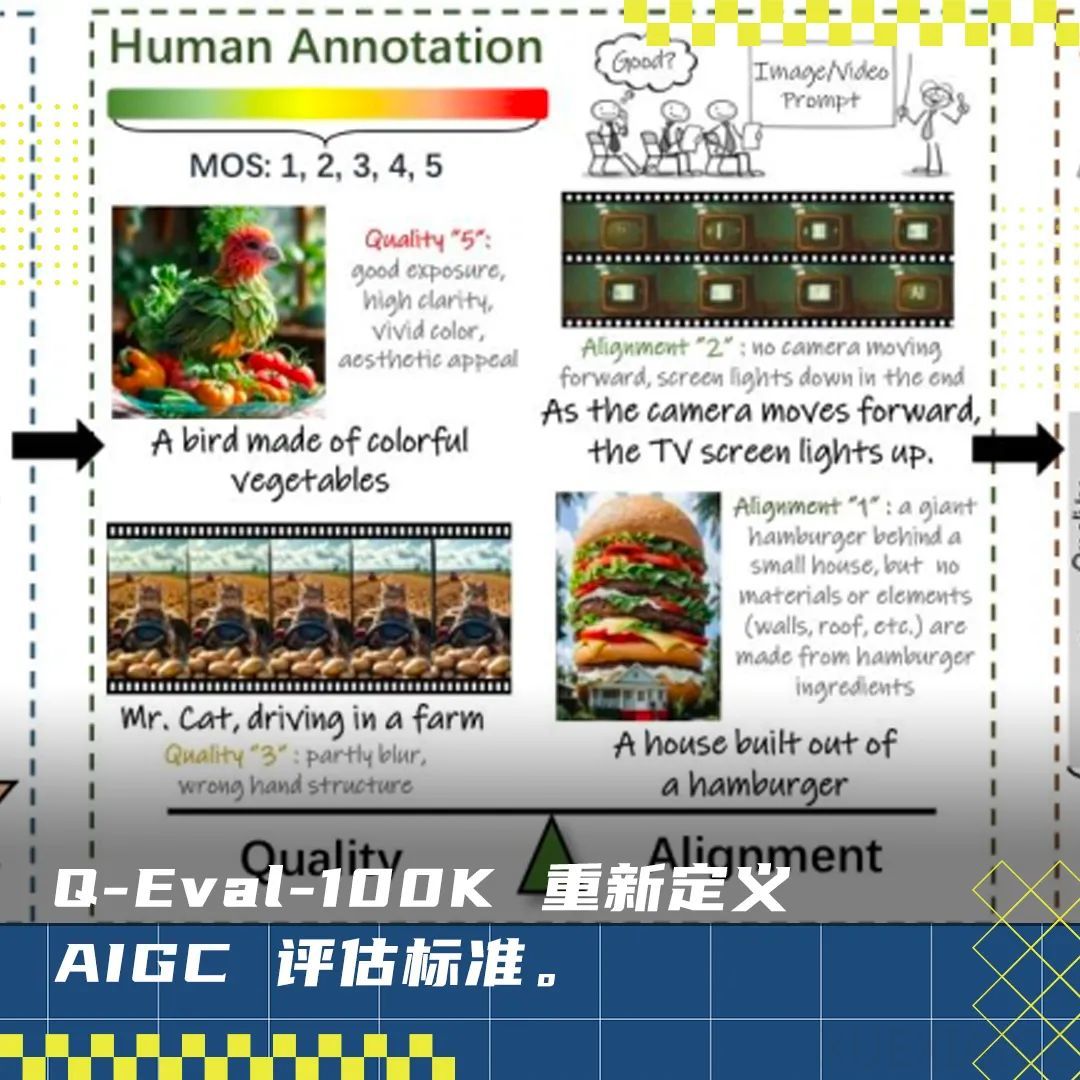

CVPR 2023年共收到13008份有效投稿,最终录用2878篇,录用率为22.1%。多模态相关内容仍然是今年研究的重点。上海交通大学-美团计算与智能联合实验室的论文被录用,提出了Q-Eval-100K数据集和Q-Eval-Score评估框架,旨在解决现有文本到视觉评估数据集在系统性、规模以及评估过程复杂性等方面的不足。Q-Eval-100K是当前最大的AIGC评估数据集,包含100K的AIGC生成数据,其中60k为图片,40k为视频。跨数据集验证表明,在Q-Eval-100K上训练的模型在GenAI-Bench数据集上表现优异,证明了其泛化能力。

在数据集构建过程中,团队遵循了三个核心原则:数据多样性、高质量标注以及视觉质量和文本一致性的解耦标注。为了确保数据多样性,团队从实体生成、实体属性生成和交叉能力项三个维度构建了prompt集,并使用了多个SOTA的AIGC模型生成数据。在标注方面,团队招募了200多名经过培训的人员,收集了超过960k条打分信息,最终筛选出100k AIGC数据及其对应的标注数据。通过解耦标注,Q-Eval-Score能够同时评估视觉质量和文本一致性,提升了评估框架的准确性和泛化能力。

基于Q-Eval-100K数据集,团队训练了Q-Eval-Score评估框架,该框架通过监督微调(SFT)将数据集转换为大语言模型的训练数据,使其能够独立评估视觉质量和文本一致性。团队选择了Qwen2-VL-7B-Instruct模型进行微调,并启用了CE Loss和MSELoss来提升模型的打分能力。在处理长prompt时,团队提出了“Vague-to-Specific”策略,将长提示词拆分为模糊提示词和具体提示词分别评估,再综合计算最终得分,有效解决了长提示词对齐问题。

实验结果表明,Q-Eval-Score在视觉质量和文本一致性评估方面均表现优异,其预测得分与人工打分的斯皮尔曼等级相关系数(SRCC)和皮尔逊线性相关系数(PLCC)超越了当前所有的SOTA模型。消融实验进一步验证了研究中提出的策略和损失函数对模型性能提升的显著贡献。Q-Eval-100K和Q-Eval-Score的出现为文本到视觉模型的评估提供了更可靠、全面的方案,推动了生成式模型的进一步发展和实际应用。

AGI-Eval评测社区致力于打造公正、可信、科学、全面的评测生态,支持用户下载和使用行业公开学术评测集,同时也鼓励用户上传个人评测集,共建开源社区。这一研究成果为文本到视觉技术的发展奠定了坚实基础,助力相关领域迈向新高度。

原文和模型

【原文链接】 阅读原文 [ 1887字 | 8分钟 ]

【原文作者】 硅星人Pro

【摘要模型】 deepseek-v3

【摘要评分】 ★★★★☆